Elon Musk elimina el radar en pos de la conducción autónoma y anuncia nuevo software la próxima semana

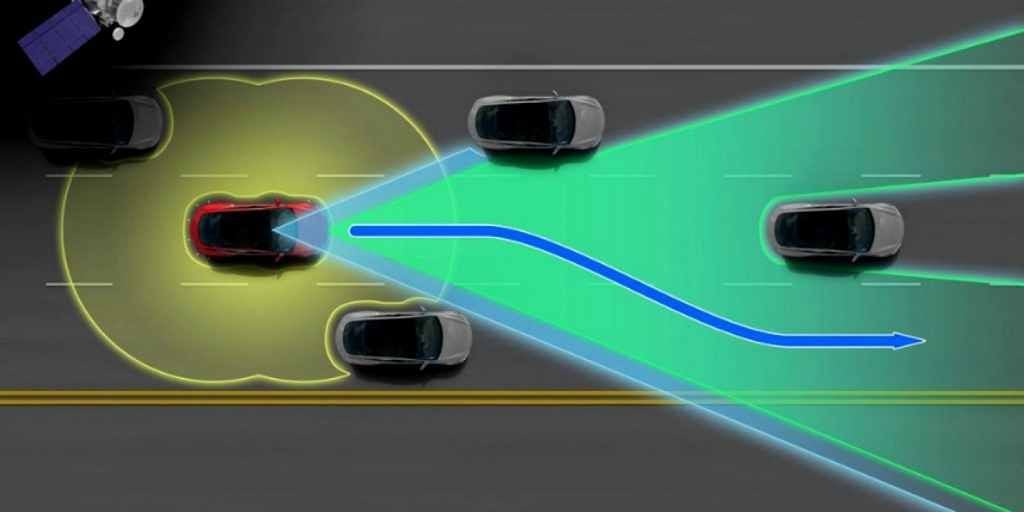

Con el objetivo de conquistar la conducción autónoma total, sin necesidad de mapas, rutas digitalizadas, lidar, sensorización y otros menesteres utilizados por empresas rivales, Elon Musk anuncia que la nueva versión beta V9 del FSD (sistema de conducción autónoma total) estará disponible la semana que viene para el exclusivo grupo de betatester en Estados Unidos.

Según anuncia Musk, “tuvimos que centrarnos en eliminar el radar y confirmar la seguridad. Ese lanzamiento saldrá la próxima semana a la producción estadounidense. Luego se lanzará una o dos semanas para pulir la visión pura FSD y v9 beta. La diferencia entre v8 y v9 es gigantesca”.

Desde ForoChochesEléctricos hemos seguido atentamente las evoluciones de esta tecnología trayendo a España la última información y vídeos publicados, por aquellos propietarios que ostentan el privilegio de disfrutar del software más avanzado de Tesla.

“Un diferencia gigantesca” y ¿sin radar?

Según Elon Musk, la diferencia respecto a la versiones actuales será “gigantesca“. Pero lo más llamativo del nuevo software es la posible eliminación de un sensor hasta ahora imprescindible en todo automóvil avanzado; el radar.

“Tuvimos que centrarnos en eliminar el radar y confirmar la seguridad“, reza el tuit de Elon Musk.El CEO de Tesla destaca el cambio del sistema de visión pura en los últimos meses.

En marzo, el CEO señaló que la visión pura es el camino a la “IA del mundo real“. El manager de origen sudafricano explicó posteriormente que la visión tiene “mucha más precisión” que el radar. Para Musk las cámaras tienen varios órdenes de magnitud, más bits por segundo que el radar.

Un objetivo en mente

El objetivo marcado por Tesla parece caminar hacia un sistema de visión pura que podría dejar atrás el radar a medida que mejore el procesamiento de visión.

En otro tuit Musk afirma que “estamos a tal vez uno o dos meses de la beta amplia. Pero estas cosas son difíciles de predecir con precisión” y añade que “el trabajo que tuvimos que hacer para la conducción de la visión pura era necesario para el FSD, se ha avanzado mucho más de lo que parece“.

Tecnología patentada

El camino de Tesla hacia la visión pura sin elementos como radar, lidar y otros elementos queda clara tras la patente publicada en marzo que describe un sistema basado en el uso de dos redes neuronales para medir con precisión las distancias de los objetos utilizando sólo datos de imagen.